„Nvidia GeForce“ grafikos kortelių šeimos žinios. „Nvidia GeForce“ grafinių kortelių šeimos pateikia nuorodą į SLI kelių lustų atvaizdavimo pakeitimus

GPU „Boost 2.0“

Su NVIDIA grafika „GeForce GTX“ 680, turime naują svarbią funkciją: „GPU Boost“. Naujasis „NVIDIA GeForce GTX Titan“ žengia dar vieną žingsnį, išplėsdamas šią funkciją į „GPU Boost 2.0“. Pirmoji „GPU Boost 1.0“ versija buvo orientuota į maksimalų energijos suvartojimą, pasiektą reikliausiuose šiuolaikiniuose žaidimuose. Tuo pačiu metu GPU temperatūra neatliko ypatingo vaidmens, išskyrus atvejus, kai ji buvo artima kritinei ribai. Didžiausias laikrodžio dažnis buvo nustatytas remiantis santykine įtampa. Trūkumas buvo visiškai akivaizdus: GPU Boost 1.0 negalėjo užkirsti kelio situacijoms, kai net ir esant nekritinei įtampai, temperatūra pernelyg padidėjo.

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„GeForce GTX Titan“ jau yra įvertinti du parametrai: įtampa ir temperatūra. Tai yra, santykinė įtampa (Vref) jau nustatyta remiantis šiais dviem parametrais. Žinoma, priklausomybė nuo atskirų GPU egzempliorių išliks, nes lustų gamyba skiriasi, todėl kiekviena vaizdo plokštė skirsis viena nuo kitos. Tačiau NVIDIA pabrėžia, kad techniškai pridėjus temperatūrą, mes galime vidutiniškai 3–7 proc. Padidinti „Boost“. Teoriškai „GPU Boost 2.0“ technologija gali būti perkelta į senesnes grafikos plokštes, tačiau vargu ar tai įvyks.

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

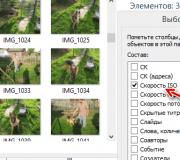

Pažvelkime iš arčiau į GPU Boost 2.0. Tokie įrankiai kaip „EVGA Precision Tool“ ar „MSI Afterburner“ jau palaiko „GPU Boost 2.0“. Mes naudojome „EVGA Precision Tool“ 4.0 versijoje.

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„GPU Boost 2.0“ yra jautrus temperatūrai, o esant žemai temperatūrai ši technologija gali žymiai padidinti našumą. Tikslinė temperatūra (Ttarget) pagal numatytuosius nustatymus yra nustatyta 80 ° C.

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„GPU Boost 2.0“ technologijoje yra visos mums žinomos savybės nuo pirmosios technologijos kartos, tačiau tuo pačiu ji papildomai leidžia nustatyti didesnę įtampą, taigi ir aukštesnį laikrodžio dažnį. „Overclockers“ vartotojams galima pakeisti nustatymus. Galima įjungti GPU viršįtampį, tačiau žinokite apie galimą vaizdo plokštės gyvenimo trukmės sumažėjimą.

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

„NVIDIA GeForce GTX Titan“ - GPU-Boost 2.0

Overclockeriai gali pakelti „Vref“ ir „Vmax“ („OverVoltaging“). To norėjo daugelis „GK104“ naudotojų, tačiau NVIDIA nepatikėjo šios funkcijos nei vartotojams, nei gamintojams. Mūsų išbandyta „EVGA GTX 680 Classified“ vaizdo plokštė (bandymas ir peržiūra) yra tik puikus pavyzdys. Ši grafikos plokštė turi specialų EVGA „Evbot“ modulį, kuris vartotojams suteikė galimybę valdyti įtampą. Tačiau NVIDIA skubiai pareikalavo, kad EVGA pašalintų papildomą aparatinę įrangą iš savo vaizdo plokščių. „GPU Boost 2.0“ ir „OverVoltaging“ atveju pati NVIDIA žengė žingsnį šia linkme. Taigi vaizdo plokščių gamintojai gali išleisti kelis „GeForce GTX Titan“ modelius, pavyzdžiui, standartines versijas ir gamykloje viršijusias versijas. Viršįtampis įjungiamas per VBIOS jungiklį (tai yra aiškiai tam, kad vartotojas žinotų galimas pasekmes).

Vaizdo plokštės „NVIDIA GeForce GTX 780“ apžvalga „GeForce“ patirtis ir „ShadowPlay“

„GeForce“ patirtis

Kaip asmeninių kompiuterių entuziastai, mes vertiname skirtingų nustatymų, turinčių įtakos žaidimų našumui ir kokybei, derinį. Lengviausias būdas yra išleisti daug pinigų nauja vaizdo plokštė ir nustatykite maksimalius grafikos parametrus. Bet kai bet kuris parametras pasirodo per sunkus kortelei ir jį reikia sumažinti arba išjungti, lieka nemalonus jausmas ir supratimas, kad žaidimas gali veikti daug geriau.

Tačiau nustatyti optimalius nustatymus nėra lengva. Kai kurie nustatymai sukuria geresnius vaizdus nei kiti, o poveikis našumui gali labai skirtis. „GeForce Experience“ yra NVIDIA pastangos supaprastinti žaidimo parametrus, lyginant jūsų procesorių, GPU ir skiriamąją gebą su konfigūracijų duomenų baze. Antroji įrankio dalis padeda nustatyti, ar tvarkyklėms reikia atnaujinimų.

Tikriausiai entuziastai ir toliau patys pasirinks nustatymus ir neigiamai suvoks papildoma programa... Tačiau dauguma žaidėjų, norinčių įdiegti žaidimą ir iškart pradėti žaisti netikrindami tvarkyklių ir nesiimdami įvairių nustatymų, tikrai bus patenkinti šia galimybe. Bet kokiu atveju NVIDIA „GeForce Experience“ padeda žmonėms kuo geriau išnaudoti žaidimą, todėl yra naudinga kompiuterinių žaidimų priemonė.

„GeForce Experience“ aptiko visus devynis žaidimus, įdiegtus mūsų bandymų sistemoje. Natūralu, kad jie neišlaikė numatytųjų nustatymų, nes testavimo tikslais pritaikėme tam tikrus nustatymus. Vis dar įdomu, kaip „GeForce Experience“ būtų pakeitusi pasirinktas parinktis.

„Tomb Raider“ „GeForce Experience“ norėjo išjungti „TressFX“ technologiją „NVIDIA GeForce GTX 780“ su įjungta funkcija ji parodė vidutiniškai 40 kadrų per sekundę. Dėl kažkokių priežasčių programa negalėjo nustatyti konfigūracijos Far Cry 3 , nors jos pasiūlyti parametrai pasirodė gana aukšti. Dėl nežinomų priežasčių „Skyrim“ norėjo išjungti FXAA.

Malonu gauti kiekvieno žaidimo ekrano kopijas, apibūdinančias konkretaus nustatymo įtaką vaizdo kokybei. Iš devynių mūsų apžvelgtų pavyzdžių „GeForce Experience“ priartėjo prie optimaliausių, mūsų nuomone, nustatymų. Tačiau naudingumas taip pat yra šališkas, globojantis specifines NVIDIA funkcijas, tokias kaip „PhysX“ (kurią programa „Borderlands 2“ pakėlė aukštai), ir neleidžiantį įgalinti AMD funkcijų (įskaitant „TressFX“ programoje „Tomb Raider“). Išjungti „FXAA“ „Skyrim“ nėra prasmės, nes žaidimas vidutiniškai siekia 100 kadrų per sekundę. Gali būti, kad entuziastai, norėdami įdiegti „NVIDIA Shield“ sistemą, norės įdiegti „GeForce Experience“, nes žaidimų srautas atrodo įgyvendinamas per „NVIDIA“ programą.

„ShadowPlay“: visada aktyvus dvr žaidimams

WoW mėgėjai dažnai įrašo savo reidus, tačiau tam reikia gana galingos sistemos, „Fraps“ ir daug vietos diske.

„NVIDIA“ neseniai paskelbė apie naują „ShadowPlay“ funkciją, kuri gali labai supaprastinti įrašymo procesą.

Suaktyvinta „ShadowPlay“ naudoja „Kepler GPU“ įmontuotą „NVEnc“ fiksuotą dekoderį, kuris automatiškai įrašo paskutines 20 žaidimo minučių. Arba galite rankiniu būdu paleisti ir sustabdyti „ShadowPlay“. Taigi ši technologija pakeičia tokius programinius sprendimus kaip „Fraps“, kurie centrinį procesorių apkrauna didesne apkrova.

Nuoroda: NVEnc veikia tik su H.264 kodavimu, skiriant iki 4096x4096 pikselių. „ShadowPlay“ dar nėra rinkoje, tačiau NVIDIA teigia, kad paleisdama šią vasarą galės įrašyti 1080p vaizdo įrašą iki 30 FPS greičiu. Mes norėtume pamatyti didesnę skiriamąją gebą, nes anksčiau buvo teigiama, kad koduotojas gali palaikyti ją aparatine įranga.

Vaizdo plokštės „NVIDIA GeForce GTX 780“ apžvalga GPU „Boost 2.0“ ir galimos įsijungimo problemos

GPU „Boost 2.0“

Peržiūroje „GeForce GTX Titan“ mums nepavyko atlikti visapusiškos antrosios kartos „NVIDIA GPU Boost“ technologijos testavimo, tačiau dabar tai turime „NVIDIA GeForce GTX 780“ ... Čia yra trumpas šios technologijos aprašymas:

„GPU Boost“ yra NVIDIA variklis, kuris koreguoja vaizdo plokščių našumą pagal apdorojamos užduoties tipą. Kaip tikriausiai žinote, žaidimai turi skirtingus GPU resursų reikalavimus. Istoriškai dažnį reikia suderinti su blogiausiu atveju. Tačiau apdorojant „lengvąsias“ užduotis GPU švaistėsi veltui. „GPU Boost“ stebi įvairius parametrus ir didina arba mažina dažnius, atsižvelgdamas į programos poreikius ir esamą situaciją.

Pirmasis „GPU Boost“ diegimas veikė neviršydamas tam tikros galios ribos (170 W atveju - „GeForce GTX 680“). Tačiau bendrovės inžinieriai suprato, kad jie gali saugiai viršyti šį lygį, jei GPU temperatūra yra pakankamai žema. Taigi našumą galima optimizuoti dar labiau.

Praktiškai „GPU Boost 2.0“ skiriasi tik tuo, kad dabar NVIDIA pagreitina dažnį, remdamasi ne energijos suvartojimo riba, o esant tam tikrai 80 laipsnių Celsijaus temperatūrai. Tai reiškia, kad dabar bus naudojamos didesnės dažnio ir įtampos vertės, kol lustas bus pašildytas iki 80 laipsnių. Atminkite, kad temperatūra daugiausia priklauso nuo ventiliatoriaus profilio ir nustatymų: kuo didesnis ventiliatoriaus greitis, tuo žemesnė temperatūra ir todėl didesnė GPU Boost vertė (ir, deja, triukšmo lygis). Ši technologija vis dar vertina situaciją kas 100 ms, todėl NVIDIA turi daug ką dirbti būsimose versijose.

Nuo temperatūros priklausantys parametrai dar labiau apsunkina testavimo procesą, palyginti su pirmąja „GPU Boost“ versija. Viskas, kas padidina ar sumažina GK110 temperatūrą, keičia lusto dažnį. Todėl sunku pasiekti nuoseklių rezultatų tarp važiavimų. Laboratorijos sąlygomis galima tikėtis stabilios aplinkos temperatūros.

Be to, verta paminėti, kad galite padidinti temperatūros ribą. Pavyzdžiui, jei norite „NVIDIA GeForce GTX 780“ sumažino 85 ar 90 laipsnių Celsijaus dažnį ir įtampą, tai galima sukonfigūruoti parametruose.

Norite, kad GK110 būtų kuo toliau nuo jūsų pasirinktos temperatūros ribos? Ventiliatoriaus kreivė „NVIDIA GeForce GTX 780“ visiškai reguliuojamas, leidžiantis nustatyti darbo ciklą pagal temperatūros vertes.

Galimos įsijungimo problemos

Per mūsų pažintį su „GeForce GTX Titan“ įmonės atstovai mums parodė vidinį įrankį, kuris gali nuskaityti įvairių jutiklių būseną: tokiu būdu supaprastinamas nestandartinių kortelių elgesio diagnozavimo procesas. Jei persijungiant, GK110 temperatūra pakyla per aukštai, net droselio metu ši informacija bus įrašyta į žurnalą.

Dabar šią funkciją įmonė įgyvendina taikydama „Precision X“ programą, kuri suaktyvina atsargumo „priežasčių“ algoritmą, jei įsijungimo metu yra veiksmų, trukdančių veiksmingai jį tęsti. Tai puiki savybė, nes nebereikia spėlioti apie galimas kliūtis. Taip pat yra OV maksimali riba, kuri praneš jums, jei pasiekėte absoliučią GPU įtampos viršūnę. Tokiu atveju yra rizika sudeginti kortelę. Galite tai laikyti pasiūlymu sumažinti įsijungimo parametrus.

Vaizdo plokštės „NVIDIA GeForce GTX 780“ apžvalga Bandymo stendas ir etalonai

| Bandymo stendo konfigūracija | |

| Procesorius | „Intel Core i7-3770K“ („Ivy Bridge“) 3,5 GHz, 4,0 GHz (40 * 100 MHz), LGA 1155, 8 MB „Shared L3“, įgalinta „Hyper-Threading“, taupoma energija |

| Pagrindinė plokštė | „Gigabyte Z77X-UD5H“ (LGA 1155), „Z77 Express“ lustų rinkinys, BIOS F15q |

| RAM | G.Skill 16GB (4 x 4GB) DDR3-1600, F3-12800CL9Q2-32GBZL @ 9-9-9-24 @ 1,5 V |

| Saugojimo įrenginys | Svarbus m4 SSD 256GB SATA 6Gb / s |

| Vaizdo plokštės | „Nvidia GeForce GTX 780 3GB“ „AMD Radeon“ HD 7990 6 GB „AMD Radeon HD 7970 GHz Edition 3 GB“ „Nvidia GeForce GTX 580“ 1,5 GB „Nvidia GeForce GTX 680 2GB“ „Nvidia GeForce GTX Titan 6 GB“ „Nvidia GeForce GTX 690 4GB“ |

| Maitinimas | „Cooler Master UCP-1000 W“ |

| Sistemos programinė įranga ir tvarkyklės | |

| OS | „Windows 8 Professional“ 64 bitų |

| „DirectX“ | „DirectX 11“ |

| Grafikas. vairuotojai | „AMD Catalyst 13.5“ („Beta 2“) „Nvidia GeForce“ leidimas 320.00 „Nvidia GeForce“ 320.18 leidimas („GeForce GTX 780“) |

Teisingas kadrų dažnis

Pastabūs skaitytojai pastebės, kad tolesniuose puslapiuose skaičiai kuklesni nei apžvalgoje. „AMD Radeon HD 7990“ ir tam yra priežastis. Anksčiau mes pateikėme sintetinius ir tikrus kadrų dažnius, o tada parodėme laiko svyravimus tarp kadrų kartu su nukritusiais ir trumpais kadrais. Faktas yra tas, kad šis metodas neatspindi realaus vaizdo plokštės jausmo, todėl būtų nesąžininga smerkti AMD, pasikliaujant sintetiniais laiko tarpo tarp kadrų rodikliais.

Štai kodėl kartu su kadrų dažnio svyravimais dabar pateikiame praktiškesnius dinaminius kadrų dažnius. Rezultatai nėra tokie aukšti, tačiau tuo pačiu metu jie yra gana iškalbingi žaidimuose, kuriuose AMD turi sunkumų.

| Testai ir nustatymai | |

| Mūšio laukas 3 | Grafikos kokybė - „Ultra“, „v-sync off“, 2560x1440, „DirectX 11“, „Hunting Hunting“, 90 sekundžių, FCAT |

| Far Cry 3 | Grafikos kokybė - „Ultra“, „DirectX 11“, „v-sync“ išjungta, 2560x1440, paleisti pasirinktinį maršrutą, 50 sekundžių, FCAT |

| Pasienio kraštai 2 | Grafikos kokybė - aukščiausia, „PhysX Low“, 16x anizotropinis filtravimas, 2560x1440, „Native Run“, FCAT |

| Hitmanas: Absoliucija | Grafikos kokybė - „Ultra“, „MSAA Off“, 2560x1440, įmontuotas etalonas, FCAT |

| Vyresnysis slenka V: „Skyrim“ | Grafikos kokybė - „Ultra“, įgalinta FXAA, 2560x1440, paleisti pasirinktą maršrutą, 25 sekundės, FCAT |

| „3DMark“ | Gaisro smūgio etalonas |

| „BioShock Infinite“ | Grafikos kokybė - „Ultra“, „DirectX 11“, difuzoriaus lauko gylis, 2560x1440, integruotas etalonas, FCAT |

| 3 krizė | Grafikos kokybė - labai aukšta, MSAA: žemos (2x), didelės raiškos tekstūros, 2560x1440, važiuojama savo maršrutu, 60 sekundžių, FCAT |

| Kapų plėšikas | Grafikos kokybė - „Ultimate“, „FXAA On“, 16x anizotropinis filtravimas, „TressFX Hair“, 2560x1440, „Run Custom“ maršrutas, 45 sekundės, FCAT |

| „LuxMark 2.0“ | 64 bitų dvejetainis, 2.0 versija, „Sala Scene“ |

| „SiSoftware Sandra 2013 Professional“ | Sandra Tech Support (inžinierius) 2013.SP1, kriptografija, finansinės analizės rezultatai |

|

|||

|

| |||

| Parametras | Vertė |

|---|---|

| Lusto kodinis vardas | GP104 |

| Gamybos technologija | 16 nm „FinFET“ |

| Tranzistorių skaičius | 7,2 mlrd |

| Pagrindinė sritis | 314 mm² |

| Architektūra | |

| „DirectX“ aparatinės įrangos palaikymas | |

| Atminties magistralė | |

| 1607 (1733) MHz | |

| Skaičiavimo vienetai | 20 srautinių daugiaprocesorių, įskaitant 2560 skaliarinių ALU slankiojo kablelio skaičiavimams pagal IEEE 754-2008 standartą; |

| Tekstūravimo kaladėlės | 160 tekstūros adresavimo ir filtravimo vienetų, palaikančių FP16 ir FP32 komponentus tekstūrose, ir trinijinio bei anizotropinio filtravimo pagalba visiems tekstūros formatams |

| Stebėkite palaikymą |

| „GeForce GTX 1080“ pamatinės grafikos plokštės specifikacijos | |

|---|---|

| Parametras | Vertė |

| Pagrindinis dažnis | 1607 (1733) MHz |

| 2560 | |

| Tekstūros vienetų skaičius | 160 |

| Maišymo blokų skaičius | 64 |

| Efektyvus atminties dažnis | 10000 (4 × 2500) MHz |

| Atminties tipas | GDDR5X |

| Atminties magistralė | 256 bitų |

| Atminties dydis | 8 GB |

| 320 GB / s | |

| apie 9 teraflopus | |

| 103 gigapikseliai / s | |

| 257 gigatexels / s | |

| Padanga | „PCI Express 3.0“ |

| Jungtys | |

| Energijos suvartojimas | iki 180 W |

| Papildomas maistas | Viena 8 kontaktų jungtis |

| 2 | |

| Rekomenduojama kaina | 599–699 USD (JAV), 54990 rublių (Rusija) |

Naujas „GeForce GTX 1080“ grafikos plokštės modelis gavo logišką pavadinimą pirmajam naujosios „GeForce“ serijos sprendimui - nuo tiesioginio pirmtako jis skiriasi tik pakeistu kartos skaitmeniu. Naujovė ne tik pakeičia svarbiausius sprendimus dabartinėje įmonės linijoje, bet ir kurį laiką tapo naujos serijos flagmanu, kol „Titan X“ buvo išleistas dar didesnės galios GPU. Po juo hierarchijoje yra jau paskelbtas „GeForce GTX 1070“ modelis, pagrįstas nuimta GP104 lusto versija, kurią mes apsvarstysime vėliau.

Naujų „Nvidia“ GPU MSRP yra atitinkamai 599 USD ir 699 USD už įprastą ir „Founders Edition“ (žr. Žemiau), o tai yra gana daug, atsižvelgiant į tai, kad „GTX 1080“ lenkia ne tik „GTX 980 Ti“, bet ir „Titan X“. Šiandien naujasis produktas yra geriausias rinkoje veikiantis vieno lusto vaizdo plokščių sprendimas be jokių klausimų ir tuo pačiu metu jis kainuoja pigiau nei produktyviausios ankstesnės kartos vaizdo plokštės. Kol kas „GeForce GTX 1080“ iš esmės neturi konkurento iš AMD, todėl „Nvidia“ galėjo nustatyti jiems tinkamą kainą.

Aptariama vaizdo plokštė yra paremta GP104 lustu su 256 bitų atminties magistrale, tačiau naujo tipo GDDR5X atmintis veikia labai aukštu efektyviu 10 GHz dažniu, o tai suteikia didžiausią 320 GB / s pralaidumo pralaidumą - tai beveik lygu GTX 980 Ti ir 384 -bitinis autobusas. Vaizdo plokštėje, turinčioje tokią magistralę, įdiegtos atminties kiekis gali būti lygus 4 arba 8 GB, tačiau būtų kvaila nustatyti mažesnį tokio galingo sprendimo tūrį šiuolaikinėmis sąlygomis, todėl „GTX 1080“ gana logiškai gavo 8 GB atminties, ir šios sumos pakanka norint paleisti bet kokį 3D kokybės nustatymus keleriems metams į priekį.

„GeForce GTX 1080“ PCB dėl akivaizdžių priežasčių padoriai skiriasi nuo ankstesnių bendrovės PCB. Tipinė naujojo produkto energijos suvartojimo vertė yra 180 W, kuri yra šiek tiek didesnė nei „GTX 980“, tačiau pastebimai mažesnė nei mažiau galingų „Titan X“ ir „GTX 980 Ti“. Etaloninėje plokštėje yra įprastas jungčių rinkinys, skirtas prijungti vaizdo išvesties įrenginius: vienas „Dual-Link DVI“, vienas HDMI ir trys „DisplayPort“.

Steigėjų leidimo informacinis dizainas

Net gegužės pradžioje paskelbus apie „GeForce GTX 1080“, buvo paskelbtas specialus vaizdo plokštės leidimas „Founders Edition“, kurio kaina yra didesnė, palyginti su įprastomis kompanijos partnerių vaizdo plokštėmis. Iš tikrųjų šis leidimas yra kortelių ir aušinimo sistemos pavyzdinis dizainas, kurį gamina pati „Nvidia“. Su tokiomis vaizdo plokščių galimybėmis galite susieti skirtingai, tačiau įmonės inžinierių sukurtas pavyzdinis dizainas ir konstrukcija, pagaminta naudojant aukštos kokybės komponentus, turi savo gerbėjų.

Bet ar jie duos dar kelis tūkstančius rublių už pačios „Nvidia“ vaizdo plokštę, į klausimą gali atsakyti tik praktika. Bet kokiu atveju, iš pradžių „Nvidia“ vaizdo plokštės pasirodys parduodamos už didesnę kainą, o rinktis nėra iš ko - taip nutinka su kiekvienu skelbimu, tačiau nuoroda „GeForce GTX 1080“ skiriasi tuo, kad planuojama ją parduoti šia forma per visą jos laikotarpį gyvenimą, iki naujos kartos sprendimų.

„Nvidia“ mano, kad šis leidimas turi savo nuopelnų net ir geriausiuose partnerių darbuose. Pavyzdžiui, dėl dviejų lizdų aušintuvo konstrukcijos, remiantis šia galinga vaizdo plokšte, lengva pastatyti tiek santykinai mažos formos žaidimų kompiuterius, tiek kelių lustų vaizdo sistemas (nors bendrovė nerekomenduoja veikti trijų ir keturių lustų režimu). „GeForce GTX 1080 Founders Edition“ turi keletą efektyvaus garų kameros aušintuvo ir ventiliatoriaus, išpūsto karštą orą iš korpuso, pranašumų - tai pirmas toks „Nvidia“ sprendimas, naudojant mažiau nei 250 W energijos.

Palyginti su ankstesniais bendrovės etaloniniais gaminiais, maitinimo grandinė buvo atnaujinta iš keturių ir penkių. „Nvidia“ taip pat kalba apie patobulintus komponentus, kuriais grindžiamas naujas produktas, taip pat apie sumažintą elektrinį triukšmą, leidžiantį pagerinti įtampos stabilumą ir įsijungimo potencialą. Dėl visų patobulinimų etaloninė plokštė yra 6% efektyvesnė energija nei „GeForce GTX 980“.

Ir norint skirtis nuo „įprastų“ „GeForce GTX 1080“ modelių ir išoriškai, „Founders Edition“ buvo sukurtas neįprastas „susmulkinto“ korpuso dizainas. Tačiau tai tikriausiai sukėlė garavimo kameros ir radiatoriaus formos komplikaciją (žr. Nuotrauką), o tai galėjo būti viena iš 100 USD priemokos už tokį specialų leidimą priežasčių. Mes kartojame, kad pardavimo pradžioje pirkėjai neturės daug pasirinkimo galimybių, tačiau ateityje jie galės pasirinkti tiek savo dizaino sprendimą iš vieno iš įmonės partnerių, tiek patį „Nvidia“.

Naujos kartos „Pascal“ grafikos architektūra

„GeForce GTX 1080“ vaizdo plokštė yra pirmasis įmonės sprendimas, pagrįstas GP104 lustu, kuris priklauso naujos kartos „Nvidia“ grafikos architektūrai - „Pascal“. Nors naujoji architektūra yra paremta „Maxwell“ sprendimais, ji taip pat turi svarbių funkcinių skirtumų, apie kuriuos mes parašysime vėliau. Pagrindinis pokytis pasauliniu požiūriu buvo naujas technologinis procesas, pagal kurį buvo pagamintas naujas grafikos procesorius.

Taivano bendrovės „TSMC“ gamyklose naudojant 16 nm „FinFET“ technologiją GP104 grafikos procesorių gamyboje buvo galima žymiai padidinti lusto sudėtingumą, išlaikant palyginti mažą plotą ir išlaidas. Palyginkite tranzistorių skaičių ir lustų GP104 bei GM204 plotą - jie yra arti savo ploto (naujovės lustas yra net šiek tiek mažesnis fiziškai), tačiau „Pascal“ architektūros lustas turi pastebimai didesnį tranzistorių skaičių ir, atitinkamai, vykdymo vienetus, įskaitant tuos, kurie teikia naują funkcionalumą.

Architektūriniu požiūriu pirmasis žaidimas „Pascal“ yra labai panašus į panašius „Maxwell“ architektūros sprendimus, nors yra keletas skirtumų. Kaip ir „Maxwell“, „Pascal“ procesoriai turės skirtingas grafikos apdorojimo grupių (GPC), srautinio perdavimo daugelio procesorių (SM) ir atminties valdiklių konfigūracijas. SM daugiaprocesorius yra labai lygiagretus daugiaprocesorius, kuris planuoja ir vykdo metmenis (metmenis, 32 komandų gijų grupes) CUDA šerdyse ir kituose daugiaprocesoriuose vykdymo blokuose. Išsamią informaciją apie visų šių blokų dizainą galite rasti ankstesnių „Nvidia“ sprendimų apžvalgose.

Kiekvienas iš SM daugiaprocesorių yra suporuotas su „PolyMorph Engine“, kuris tvarko tekstūros gavimą, keliavimą, transformavimą, viršūnių atributų nustatymą ir perspektyvos korekciją. Skirtingai nuo ankstesnių kompanijos sprendimų, GP104 luste esančiame „PolyMorph Engine“ taip pat yra naujas „Vienalaikio daugiaprojekcijos“ įrenginys, kurį aptarsime toliau. SM daugiaprocesoriaus ir vieno „Polymorph Engine“ derinys tradiciškai vadinamas „TPC“ - „Nvidia“ tekstūros procesoriaus klasteriu.

Iš viso „GeForce GTX 1080“ GP104 luste yra keturi GPC klasteriai ir 20 SM daugiaprocesorių, taip pat aštuoni atminties valdikliai kartu su 64 ROP įrenginiais. Kiekvienas GPC turi specialų rastravimo variklį ir apima penkis SM daugiaprocesorius. Kiekvieną daugiaprocesorių savo ruožtu sudaro 128 CUDA šerdys, 256 KB registro failas, 96 KB bendrosios atminties, 48 \u200b\u200bKB L1 talpyklos ir aštuoni TMU tekstūros vienetai. Tai yra, iš viso GP104 yra 2560 CUDA branduolių ir 160 TMU.

Be to, grafikos procesoriuje, kuriuo paremta „GeForce GTX 1080“, yra aštuoni 32 bitų (priešingai nei anksčiau naudoti 64 bitų) atminties valdikliai, o tai suteikia mums galutinę 256 bitų atminties magistralę. Aštuoni ROP ir 256 KB L2 talpyklos yra susietos su kiekvienu atminties valdikliu. Tai yra, GP104 luste yra 64 ROP ir 2048 KB L2 talpyklos.

Dėl architektūros optimizavimo ir naujos procesų technologijos pirmasis žaidimų „Pascal“ tapo visų laikų efektyviausiu GPU. Be to, prie to prisideda vienas pažangiausių 16 nm „FinFET“ technologinių procesų ir Pascalo architektūros optimizavimas, palyginti su „Maxwell“. „Nvidia“ sugebėjo padidinti laikrodžio greitį dar labiau, nei tikėjosi pereidama prie naujos procesų technologijos. GP104 veikia didesniu dažniu, nei veiktų hipotetinis GM204, pagamintas naudojant 16 nm procesų technologiją. Norėdami tai padaryti, „Nvidia“ inžinieriai turėjo atidžiai patikrinti ir optimizuoti visas ankstesnių sprendimų kliūtis, kurios neleido persijungti virš tam tikros ribos. Todėl naujasis „GeForce GTX 1080“ veikia daugiau nei 40% greičiau nei „GeForce GTX 980“. Tačiau tai dar ne visi GPU laikrodžio pokyčiai.

GPU „Boost 3.0“ technologija

Kaip gerai žinome iš ankstesnių „Nvidia“ vaizdo plokščių, jie savo GPU naudoja aparatūros technologiją „GPU Boost“, skirtą padidinti GPU veikimo laikrodžio dažnį režimais, kai jis dar nepasiekė energijos suvartojimo ir šilumos išsklaidymo ribų. Per daugelį metų šis algoritmas patyrė daug pokyčių, o trečioji šios technologijos karta naudojama „Pascal“ architektūros vaizdo luste - „GPU Boost 3.0“, kurio pagrindinė naujovė yra smulkesnis turbo dažnių nustatymas, atsižvelgiant į įtampą.

Jei prisiminsite ankstesnių technologijos versijų veikimo principą, tada skirtumas tarp bazinio dažnio (garantuojamos minimalios dažnio vertės, žemiau kurios GPU nenukrenta, bent jau žaidimuose) ir turbo dažnio buvo fiksuotas. Tai yra, turbo dažnis visada buvo tam tikras megahercų skaičius didesnis nei bazinis. „GPU Boost 3.0“ pristato galimybę nustatyti turbo dažnio poslinkius kiekvienai įtampai atskirai. Lengviausia tai suprasti iš iliustracijos:

Kairėje yra antrosios versijos „GPU Boost“, dešinėje - trečioji, pasirodžiusi „Pascal“. Fiksuotas skirtumas tarp bazinio ir turbo dažnių neleido iki galo atskleisti GPU galimybių, kai kuriais atvejais ankstesnės kartos GPU galėjo veikti greičiau, kai nustatyta įtampa, tačiau fiksuotas turbo dažnio perteklius to neleido. „GPU Boost 3.0“ tokia galimybė atsirado, o turbo dažnį galima nustatyti kiekvienai atskirai įtampos vertei, visiškai išspaudžiant visas sultis iš GPU.

Patogios komunalinės paslaugos reikalingos norint valdyti įsijungimą ir nustatyti turbo dažnio kreivę. Pati „Nvidia“ to nedaro, tačiau padeda savo partneriams sukurti tokias komunalines paslaugas, kad būtų lengviau įsijungti (žinoma, protingose \u200b\u200bribose). Pavyzdžiui, nauja „GPU Boost 3.0“ funkcionalumas jau buvo pristatytas „EVGA Precision XOC“, kuriame yra specialus įsijungimo skaitytuvas, kuris, atlikdamas integruotą našumo ir stabilumo testą, automatiškai nustato ir nustato netiesinį skirtumą tarp pagrindinio dažnio ir turbo dažnio skirtingoms įtampoms. Dėl to vartotojas turi turbo dažnio kreivę, kuri puikiai atitinka konkretaus lusto galimybes. Be to, jį bet kokiu būdu galima modifikuoti rankiniu būdu.

Kaip matote įrankio ekrane, be informacijos apie GPU ir sistemą, taip pat yra nustatymai, kaip įsijungti: „Power Target“ (nustato įprastą energijos suvartojimą persijungiant, procentais nuo standarto), „GPU Temp Target“ (maksimali leistina pagrindinė temperatūra), GPU Clock Offset (bazinio dažnio perteklius visoms įtampoms), atminties poslinkis (vaizdo atminties dažnio perviršis virš numatytosios vertės), viršįtampis (papildoma galimybė padidinti įtampą).

„Precision XOC Utility“ apima tris įsijungimo režimus: „Basic Basic“, „Linear Linear“ ir „Manual Manual“. Pagrindiniame režime galite nustatyti vieną pagrindinio dažnio vertę (fiksuotą turbo dažnį), kaip tai buvo ankstesniuose GPU. Linijinis režimas leidžia nustatyti dažnį nuo minimalios iki didžiausios GPU įtampos vertės. Na, rankiniu režimu kiekvienam grafiko įtampos taškui galite nustatyti unikalias GPU dažnio reikšmes.

Naudingoje programoje taip pat yra specialus skaitytuvas, skirtas automatiniam greitinimui. Galite nustatyti savo dažnio lygius arba leisti „Precision XOC“ nuskaityti GPU esant bet kokiai įtampai ir visiškai automatiškai rasti stabiliausius kiekvieno įtampos ir dažnio kreivės taško dažnius. Nuskaitymo metu „Precision XOC“ palaipsniui didina GPU dažnį ir tikrina jo veikimą, ar nėra stabilumo ar artefaktų, sukuriant idealią dažnio ir įtampos kreivę, kuri bus unikali kiekvienam lustui.

Šį skaitytuvą galima pritaikyti pagal jūsų poreikius, nustatant kiekvienos įtampos vertės testavimo laiko intervalą, mažiausią ir didžiausią bandomą dažnį bei jo žingsnį. Akivaizdu, kad norint pasiekti stabilių rezultatų, geriau būtų nustatyti mažą žingsnį ir deramą testavimo trukmę. Testavimo metu gali būti stebimas nestabilus vaizdo tvarkyklės ir sistemos veikimas, tačiau jei skaitytuvas neužšąla, jis atkuria veikimą ir toliau randa optimalius dažnius.

Naujo tipo vaizdo atmintis GDDR5X ir patobulintas glaudinimas

Taigi, GPU galia pastebimai išaugo, o atminties magistralė išlieka tik 256 bitų - ar atminties pralaidumas ribos bendrą našumą ir ką galima padaryti? Panašu, kad perspektyvios antrosios kartos HBM atminties gamyba vis dar yra per brangi, todėl reikėjo ieškoti kitų variantų. Nuo pat GDDR5 atminties pristatymo 2009 m. „Nvidia“ inžinieriai tyrinėjo naujų tipų atminties naudojimo galimybes. Todėl plėtojant buvo pristatytas naujas GDDR5X atminties standartas - pats sudėtingiausias ir pažangiausias šiuo metu standartas, suteikiantis 10 Gbps perdavimo greitį.

„Nvidia“ pateikia įdomų pavyzdį, kaip greitai. Tarp perduotų bitų praeina tik 100 pikosekundžių - per šį laiką šviesos pluoštas įveikia tik vieno colio (apie 2,5 cm) atstumą. Naudojant „GDDR5X“ atmintį, duomenų perdavimo ir priėmimo grandinės per mažiau nei pusę šio laiko, prieš išsiųsdamos kitą, turi pasirinkti perduoto bitų vertę - tai tik tam, kad suprastumėte, kokios šiuolaikinės technologijos atsirado.

Norint pasiekti tokį greitį, reikėjo sukurti naują duomenų įvesties / išvesties sistemos architektūrą, kuriai prireikė kelerių metų bendro kūrimo su atminties lustų gamintojais. Be padidėjusio duomenų perdavimo greičio, padidėjo ir energijos vartojimo efektyvumas - GDDR5X atminties lustai naudoja mažesnę įtampą 1,35 V ir yra gaminami naudojant naujas technologijas, kurios suteikia tą patį energijos suvartojimą 43% didesniu dažniu.

Bendrovės inžinieriai turėjo pertvarkyti duomenų perdavimo linijas tarp GPU šerdies ir atminties lustų, daugiau dėmesio skirdami signalų praradimo ir degradacijos prevencijai nuo pat atminties iki GPU ir atgal. Pavyzdžiui, aukščiau pateiktoje iliustracijoje užfiksuotas signalas parodomas kaip didelė simetriška „akis“, o tai rodo gerą visos grandinės optimizavimą ir santykinį duomenų surinkimo iš signalo lengvumą. Be to, dėl aukščiau aprašytų pakeitimų atsirado ne tik galimybė naudoti GDDR5X 10 GHz dažniu, bet ir tai turėtų padėti gauti didelį atminties pralaidumą būsimiems produktams, naudojant labiau pažįstamą GDDR5 atmintį.

Na, naudodami naują atmintį gavome daugiau nei 40% atminties pralaidumo padidėjimo. Bet ar to nepakanka? Siekdama dar labiau pagerinti atminties pralaidumo efektyvumą, „Nvidia“ toliau tobulino pažangesnį duomenų glaudinimą, įdiegtą ankstesnėse architektūrose. „GeForce GTX 1080“ atminties posistemėje naudojami patobulinti ir keli nauji duomenų be duomenų praradimo būdai, sukurti siekiant sumažinti atminties pralaidumo reikalavimus - ketvirtosios lustų glaudinimo kartos.

Duomenų atmintyje suspaudimo algoritmai suteikia keletą privalumų vienu metu. Suspaudimas sumažina į atmintį įrašytų duomenų kiekį, tas pats pasakytina apie duomenis, perkeliamus iš vaizdo atminties į L2 talpyklą, o tai pagerina L2 talpyklos efektyvumą, nes suspaustos plytelės (kelių kadrų buferio pikselių blokas) dydis yra mažesnis nei nesuspausto. Tai taip pat sumažina duomenų, siunčiamų tarp skirtingų taškų, pvz., TMU tekstūros vienetą ir rėmelių buferį, kiekį.

Duomenų glaudinimo vamzdynas GPU naudoja kelis algoritmus, kurie nustatomi atsižvelgiant į duomenų „suspaudžiamumą“ - jiems parenkamas geriausias turimas algoritmas. Vienas svarbiausių yra delta spalvų glaudinimo algoritmas. Šis glaudinimo metodas užkoduoja duomenis kaip skirtumą tarp nuoseklių reikšmių, o ne pačius duomenis. GPU apskaičiuoja spalvų reikšmių skirtumą tarp bloko (plytelių) pikselių ir išsaugo bloką kaip tam tikrą vidutinę viso bloko spalvą, taip pat duomenis apie kiekvieno pikselio reikšmių skirtumą. Grafiniams duomenims šis metodas paprastai tinka, nes mažų plytelių spalva visiems pikseliams dažnai nėra labai skirtinga.

„GeForce GTX 1080“ esantis GP104 GPU palaiko daugiau suspaudimo algoritmų nei ankstesni „Maxwell“ lustai. Taigi, 2: 1 glaudinimo algoritmas tapo efektyvesnis, be to, atsirado du nauji algoritmai: 4: 1 suspaudimo režimas, tinkamas tais atvejais, kai bloko taškų spalvų vertės skirtumas yra labai mažas, ir 8: 1 režimas, jungiantis pastoviąją 2: 2 pikselių blokų 4: 1 glaudinimo santykis su 2x delta suspaudimu tarp blokų. Kai suspaudimas visai neįmanomas, jis nenaudojamas.

Tačiau iš tikrųjų pastarieji pasitaiko labai retai. Tai matyti iš žaidimo „Project CARS“ ekrano kopijų pavyzdžių, kuriuos „Nvidia“ atnešė iliustruodamas padidėjusį „Pascal“ suspaudimo laipsnį. Iliustracijose tos rėmelių buferio plytelės, kurias GPU sugebėjo suspausti, nudažytos violetine spalva, o nuostolingos liko su originalia spalva (viršuje - Maxwell, apačioje - Pascal).

Kaip matote, nauji GP104 suspaudimo algoritmai iš tikrųjų veikia daug geriau nei „Maxwell“. Nors senoji architektūra taip pat sugebėjo suspausti didžiąją dalį scenos plytelių, daugybė žolių ir medžių aplink kraštus, taip pat mašinų dalys, nėra taikomi seniems suspaudimo algoritmams. Tačiau Pascale įdiegus naujas technikas, labai nedaug vaizdo sričių liko nesuspaustos - akivaizdus padidėjęs efektyvumas.

Dėl duomenų glaudinimo patobulinimų „GeForce GTX 1080“ sugeba žymiai sumažinti vienam kadrui siunčiamų duomenų kiekį. Kalbant apie skaičius, patobulintas glaudinimas sutaupys papildomus 20% efektyvaus atminties pralaidumo. Be daugiau nei 40% didesnio „GeForce GTX 1080“ atminties pralaidumo, palyginti su „GTX 980“, naudojant GDDR5X atmintį, visa tai kartu suteikia apie 70% efektyvesnio atminties pralaidumo padidėjimą, palyginti su ankstesnės kartos modeliu.

„Async Compute“ palaikymas

Daugumoje šiuolaikinių žaidimų, be grafinių, naudojami sudėtingi skaičiavimai. Pavyzdžiui, skaičiavimai skaičiuojant fizinių kūnų elgesį gali būti atliekami ne prieš grafinius skaičiavimus ar po jų, bet kartu su jais, nes jie nėra susiję tarpusavyje ir nepriklauso vienas nuo kito tame pačiame kadre. Be to, pavyzdys yra jau atvaizduotų kadrų ir garso duomenų apdorojimas, kuris taip pat gali būti atliekamas lygiagrečiai su pateikimu.

Kitas puikus funkcionalumo naudojimo pavyzdys yra „Asynchronous Time Warp“ technika, naudojama VR sistemose, norint pakeisti pateiktą kadrą, kad jis atitiktų žaidėjo galvos judesį prieš jį perteikiant, nutraukiant kitą atvaizdavimą. Toks asinchroninis GPU galios pakrovimas leidžia padidinti jo vykdymo vienetų naudojimo efektyvumą.

Šie darbo krūviai sukuria du naujus GPU naudojimo atvejus. Pirmasis iš jų apima sutampančias apkrovas, nes daugelio tipų užduotys ne visiškai išnaudoja GPU galimybes, o kai kurie ištekliai neveikia. Tokiais atvejais jūs galite tiesiog paleisti dvi skirtingas užduotis viename GPU, kurie atskiria jo vykdymo vienetus, kad būtų efektyviau naudojamas, pavyzdžiui, „PhysX“ efektai, kurie atliekami kartu su 3D kadrų atvaizdavimu.

Siekiant pagerinti šio scenarijaus efektyvumą, „Pascal“ architektūroje buvo įdiegtas dinamiškas apkrovos balansavimas. Ankstesnėje „Maxwell“ architektūroje persidengiantys darbo krūviai buvo įgyvendinti kaip statinis GPU išteklių paskirstymas grafikai ir skaičiavimams. Šis metodas yra veiksmingas, jei pusiausvyra tarp dviejų darbo krūvių apytiksliai atitinka išteklių pasiskirstymą ir užduotys atliekamos tuo pačiu metu. Jei ne grafiniai skaičiavimai užtruks ilgiau nei grafiniai, ir abu laukia bendro darbo pabaigos, tai dalis GPU likusį laiką neveiks, o tai sumažins bendrą našumą ir panaikins visus privalumus. Dinaminis aparatūros apkrovos balansavimas leidžia atlaisvintus GPU išteklius naudoti iškart, kai tik jie tampa prieinami - štai iliustracija supratimui.

Taip pat yra užduočių, kurios yra labai svarbios vykdymo laikui, ir tai yra antrasis asinchroninio skaičiavimo scenarijus. Pavyzdžiui, asinchroninio laiko iškraipymo algoritmo vykdymas VR turi būti baigtas prieš nuskaitymą (nuskaitymą) arba kadras bus atmestas. Tokiu atveju GPU turi palaikyti labai greitą užduoties nutraukimą ir pereiti prie kito, kad pašalintų mažiau kritinę užduotį iš GPU vykdymo, atlaisvindami savo išteklius kritinėms užduotims - tai vadinama išankstiniu nusistatymu.

Vienoje žaidimo variklio atvaizdavimo komandoje gali būti šimtai piešimo skambučių, kiekviename piešimo kvietime savo ruožtu yra šimtai apdorotų trikampių, kurių kiekviename yra šimtai taškų, kuriuos reikia apskaičiuoti ir nupiešti. Tradicinis GPU metodas naudoja tik aukšto lygio užduočių pertraukimą, o grafikos dujotiekis turi laukti, kol visas šis darbas bus baigtas, prieš perjungdamas užduotį, o tai lemia labai dideles delsas.

Norėdami tai išspręsti, „Pascal“ architektūra pirmoji pristatė galimybę pertraukti užduotį pikselių lygiu - „Pixel Level Preempt“. „Pascal“ GPU vykdymo blokai gali nuolat stebėti užduočių pateikimo eigą, o kai prašoma pertraukti, jie gali sustabdyti vykdymą, išsaugodami kontekstą, kad vėliau juos užbaigtų, greitai perėję prie kitos užduoties.

Skaičiavimo operacijų pertraukimas ir perjungimas gijų lygiu veikia panašiai kaip grafikos skaičiavimo pikselių lygiu. Skaičiavimo darbo krūviai susideda iš kelių tinklelių, kurių kiekviename yra daug gijų. Kai gaunama pertraukimo užklausa, daugiaprocesoriuje veikiančios gijos nutraukia vykdymą. Kiti blokai išsaugo savo būseną ir tęsiasi iš to paties taško ateityje, o GPU pereina prie kitos užduoties. Visas užduočių perjungimo procesas užtrunka mažiau nei 100 mikrosekundžių, kai baigiasi veikiančios gijos.

Žaidimų darbo krūviui derinti pikselių lygio pertraukimus grafikai ir gijų lygio pertraukas skaičiavimo užduotims suteikti „Pascal“ GPU galimybę greitai pereiti iš vienos užduoties į minimalų laiko švaistymą. Ir atliekant skaičiavimo užduotis CUDA, taip pat galimas pertraukimas su minimaliu detalumu - instrukcijų lygiu. Šiuo režimu visos gijos nedelsiant sustabdomos, nedelsiant pereinama prie kitos užduoties. Šis metodas reikalauja saugoti daugiau informacijos apie kiekvieno gijos visų registrų būseną, tačiau kai kuriais atvejais tai nėra pagrįsta.

Greito pertraukimo ir užduočių perjungimo naudojimas grafikoje ir skaičiavimo užduotyse buvo pridėtas prie „Pascal“ architektūros, kad grafikos ir ne grafikos užduotis būtų galima nutraukti atskirų instrukcijų lygiu, o ne ištisomis gijomis, kaip buvo Maxwell ir Kepler. Šios technologijos gali pagerinti asinchroninį įvairių GPU darbo krūvių vykdymą ir pagerinti reagavimą atliekant kelias užduotis vienu metu. Renginyje „Nvidia“ pademonstravo asinchroninį skaičiavimą naudodama fizinių efektų skaičiavimo pavyzdį. Jei be asinchroninio skaičiavimo našumas buvo 77–79 FPS lygio, tai įtraukus šias funkcijas kadrų dažnis padidėjo iki 93–94 FPS.

Kaip pavyzdį jau minėjome vieną iš galimybių naudoti šią funkciją žaidimuose kaip asinchroninį laiko iškraipymą VR. Iliustracijoje parodyta, kaip ši technologija veikia iš anksto ir greitai pertraukiama. Pirmuoju atveju asinchroninio laiko iškraipymo procesą bandoma atlikti kuo vėliau, bet prieš pradedant atnaujinti vaizdą ekrane. Tačiau algoritmo darbą reikia atiduoti GPU keliomis milisekundėmis anksčiau, nes be greito pertraukimo nėra galimybės tiksliai atlikti darbą tinkamu momentu, o GPU kurį laiką neveikia.

Tikslių pertraukimų atveju pikselių ir srauto lygyje (iliustracijoje dešinėje) tai leidžia tiksliau nustatyti pertraukimo momentą, o asinchroninį laiko iškraipymą galima sukelti daug vėliau, pasitikint darbo pabaiga, kol informacija atnaujinama ekrane. Pirmuoju metu kurį laiką neveikiančiame GPU galima įkrauti papildomą grafinį darbą.

Vienalaikė daugiaprojekcinė technologija

Naujasis GP104 GPU papildo naują „Vienalaikio daugiaprojekcijos“ (SMP) technologiją, kuri leidžia GPU efektyviau pateikti duomenis šiuolaikinėse vaizdavimo sistemose. SMP leidžia vaizdo lustui vienu metu rodyti duomenis keliose projekcijose, todėl prieš rasterizavimo įrenginį geometrijos dujotiekio gale reikėjo įvesti naują aparatūros vienetą GPU į „PolyMorph“ variklį. Šis blokas yra atsakingas už darbą su keliomis vienos geometrijos srauto projekcijomis.

Daugiaprojekcinis variklis geometrinius duomenis vienu metu apdoroja 16 iš anksto sukonfigūruotų projekcijų, kurios sujungia projekcijos tašką (kamerą), šias projekcijas galima savarankiškai pasukti arba pakreipti. Kadangi kiekvienas geometrijos primityvas gali pasirodyti vienu metu keliose projekcijose, SMP variklis suteikia šią funkciją, leidžiant programai nurodyti GPU pakartoti geometriją iki 32 kartų (16 projekcijų dviejuose projekcijos centruose) be papildomo apdorojimo.

Visas apdorojimo procesas yra pagreitintas aparatine įranga, ir kadangi daugiaprojekcija veikia po geometrijos variklio, nereikia kartoti visų geometrijos apdorojimo etapų kelis kartus. Sutaupyti ištekliai yra svarbūs, kai atvaizdavimo greitį riboja geometrijos apdorojimo našumas, pavyzdžiui, tessellation, kai tas pats geometrijos darbas atliekamas kelis kartus kiekvienai projekcijai. Atitinkamai, esant didžiausiai projekcijai, daugialypė projekcija gali sumažinti geometrijos apdorojimo poreikį iki 32 kartų.

Bet kodėl visa tai reikalinga? Yra keletas gerų pavyzdžių, kai kelių projekcijų technologija gali būti naudinga. Pavyzdžiui, kelių ekranų sistema, sudaryta iš trijų ekranų, įrengtų vienas kitam kampu pakankamai arti vartotojo (erdvinės konfigūracijos). Tipiškoje situacijoje scena perteikiama vienoje projekcijoje, o tai lemia geometrinį iškraipymą ir neteisingą geometrijos perteikimą. Teisingas kiekvieno monitoriaus kelias yra trys skirtingos projekcijos, atsižvelgiant į kampą, kuriuo jie yra išdėstyti.

Naudojant vaizdo plokštę mikroschemoje su „Pascal“ architektūra, tai galima padaryti vienu geometriniu perdavimu, nurodant tris skirtingas projekcijas, kiekviena savo monitoriui. Taigi vartotojas galės pakeisti monitorių išdėstymo kampą vienas kitam ne tik fiziškai, bet ir virtualiai - sukdamas šoninių monitorių projekcijas, kad gautų teisingą perspektyvą 3D scenoje su pastebimai platesniu matymo kampu (FOV). Tačiau yra apribojimas - norint gauti tokį palaikymą, programa turi sugebėti pateikti sceną su plačiu FOV ir naudoti jai specialius SMP API iškvietimus. Tai yra, jūs negalite to padaryti kiekviename žaidime, jums reikia specialaus palaikymo.

Bet kokiu atveju vienos projekcijos ant vieno plokščiaekranio monitoriaus dienos praėjo, dabar yra daugybė kelių monitorių konfigūracijų ir išlenktų ekranų, kurie taip pat gali naudoti šią technologiją. Jau nekalbant apie virtualios realybės sistemas, kurios naudoja specialius lęšius tarp ekranų ir vartotojo akių, kuriai reikalingos naujos 3D vaizdo projektavimo į 2D vaizdą technikos. Daugelis šių technologijų ir metodų dar tik kuriamos, svarbiausia yra tai, kad senesni GPU negali efektyviai naudoti daugiau nei vienos plokštumos projekcijos. Jiems reikalingi keli atvaizdavimo leidimai, keli tos pačios geometrijos apdorojimai ir pan.

„Maxwell“ lustai turėjo ribotą „Multi-Resolution“ palaikymą, kad padėtų padidinti efektyvumą, tačiau „Pascal“ SMP gali padaryti daug daugiau. Maksvelas galėjo pasukti projekciją 90 laipsnių kampu atvaizduodamas kubus ar skirtingas projekcijos skiriamąsias gebas, tačiau tai buvo naudinga tik ribotam skaičiui programų, pvz., VXGI.

Kitos SMP naudojimo galimybės apima atvaizdavimą skirtingomis skiriamosiomis gebomis ir vieno perdavimo stereofoninį atvaizdavimą. Pvz., Atvaizdavimas skirtingomis raiškomis („Multi-Res Shading“) gali būti naudojamas žaidimuose, siekiant optimizuoti našumą. Taikant, kadro centre naudojama didesnė skiriamoji geba, o periferijoje ji sumažinama, kad gautų didesnį vaizdavimo greitį.

Vienkartinis stereofoninis perteikimas naudojamas VR ir jau buvo pridėtas prie „VRWorks“ ir naudoja daugelio projekcijų galimybę sumažinti geometrinių darbų, reikalingų VR atvaizdavimui, kiekį. Naudojant šią funkciją, „GeForce GTX 1080 GPU“ scenos geometriją apdoroja tik vieną kartą, iš karto sukuria po dvi projekcijas kiekvienai akiai, o tai sumažina GPU geometrinę apkrovą perpus, taip pat sumažina vairuotojo ir OS nuostolius.

Dar tobulesnė VR atvaizdavimo efektyvumo didinimo technika yra „Lens Matched Shading“, kuris imituoja geometrinius iškraipymus, reikalingus VR atvaizdavimui naudojant kelias projekcijas. Šis metodas naudoja daugiaprojekciją, kad 3D siužetas būtų pavaizduotas ant paviršiaus, kuris maždaug panašus į pataisytą objektyvą, kai jis pateikiamas išvesties į VR ausines, taip išvengiant daugybės papildomų taškų periferijoje, kurie bus išmesti. Lengviausias būdas suprasti metodo esmę yra iliustravimas - priešais kiekvieną akį naudojamos keturios šiek tiek išskleistos projekcijos (Pascal kalboje kiekvienai akiai galite naudoti 16 projekcijų - tiksliau išlenkto lęšiuko imitacijai), o ne vieną:

Toks požiūris gali sutaupyti daug produktyvumo. Taigi, „Oculus Rift“ tipinis vaizdas yra 1,1 megapikselio akiai. Tačiau dėl projekcijų skirtumų originalus 2,1 megapikselio vaizdas naudojamas jam perteikti - 86% daugiau nei reikia! Daugiaprojekcijos, įdiegtos „Pascal“ architektūroje, naudojimas leidžia sumažinti pateikto vaizdo skiriamąją gebą iki 1,4 megapikselio, pusantro karto sutaupant pikselių apdorojimo greitį, taip pat taupomas atminties pralaidumas.

Kartu su dvigubu geometrinio apdorojimo greičio taupymu dėl vienkartinio stereofoninio perteikimo, „GeForce GTX 1080“ vaizdo plokštės grafinis procesorius gali žymiai padidinti VR atvaizdavimo našumą, o tai labai reikalauja geometrijos apdorojimo greičio ir dar labiau dėl pikselių apdorojimo.

Video duomenų išvesties ir apdorojimo blokų tobulinimas

Be našumo ir naujų funkcijų, susijusių su 3D atvaizdavimu, turi būti išlaikytas geras vaizdo išvesties ir vaizdo iškodavimo bei kodavimo pajėgumas. Ir pirmasis „Pascal“ architektūros GPU nenuvylė - jis palaiko viską šiuolaikinius standartus šia prasme, įskaitant HEVC formato aparatinį dekodavimą, reikalingą 4K vaizdo įrašams peržiūrėti kompiuteryje. Be to, būsimi „GeForce GTX 1080“ vaizdo plokščių savininkai netrukus galės mėgautis 4K vaizdo transliacija iš „Netflix“ ir kitų savo sistemų teikėjų.

Kalbant apie ekrano išvestį, „GeForce GTX 1080“ turi HDMI 2.0b palaikymą su „HDCP 2.2“ ir „DisplayPort“. Iki šiol „DP 1.2“ buvo sertifikuota, tačiau GPU yra paruoštas sertifikuoti naujesnėms standarto versijoms: „DP 1.3 Ready“ ir „DP 1.4 Ready“. Pastarasis leidžia rodyti vaizdus 4K ekranuose 120 Hz dažniu, o 5K ir 8K ekranuose esant 60 Hz dažniui, naudojant porą „DisplayPort 1.3“ laidų. Jei „GTX 980“ maksimali palaikoma skiriamoji geba buvo 5120 × 3200 esant 60 Hz, tai naujo modelio „GTX 1080“ ji padidėjo iki 7680 × 4320 tuo pačiu 60 Hz dažniu. Nuorodoje „GeForce GTX 1080“ yra trys „DisplayPort“ išėjimai, vienas HDMI 2.0b ir vienas skaitmeninis „Dual-Link DVI“.

Naujas „Nvidia“ vaizdo plokštės modelis taip pat gavo patobulintą vaizdo duomenų dekodavimo ir kodavimo įrenginį. Pavyzdžiui, GP104 lustas atitinka aukštus „PlayReady 3.0“ (SL3000) vaizdo įrašų srauto perdavimo standartus, užtikrinant, kad aukštos kokybės turinys iš garsių tiekėjų, tokių kaip „Netflix“, būtų grojamas aukščiausios kokybės ir energijos vartojimo efektyvumu. Išsami informacija apie įvairių vaizdo formatų palaikymą kodavimui ir dekodavimui pateikiama lentelėje. Naujas produktas aiškiai skiriasi nuo ankstesnių geresnių sprendimų:

Tačiau dar įdomesnę naujovę galima pavadinti vadinamojo didelio dinaminio diapazono (HDR) ekranų, kurie netrukus bus plačiai paplitę rinkoje, palaikymu. Televizoriai parduodami 2016 m. (Ketverius milijonus HDR televizorių planuojama parduoti tik per vienerius metus), o monitoriai - kitais metais. HDR yra didžiausias per pastaruosius metus įvykdytas ekrano technologijos proveržis, suteikiantis dvigubai daugiau spalvų tonų (75% matomo spektro, palyginti su 33% RGB), ryškesnius ekranus (1000 nitų) ir didesnį kontrastą (10000: 1). ir sodrios spalvos.

Atsiradus galimybei atgaminti turinį su didesniu ryškumo skirtumu ir sodresnėmis bei labiau prisotintomis spalvomis, vaizdas ekrane priartės prie tikrovės, juodaodžiai taps gilesni, o ryški šviesa apakins, kaip ir realiame pasaulyje. Todėl vartotojai matys daugiau informacijos ryškiose ir tamsiose vaizdų srityse, palyginti su standartiniais monitoriais ir televizoriais.

Norėdami palaikyti HDR ekranus, „GeForce GTX 1080“ turi viską, ko jums reikia - galimybę perkelti 12 bitų spalvas, palaikymą „BT.2020“ ir „SMPTE 2084“ standartams ir vaizdo išvestį pagal HDMI 2.0b 10/12 bitų HDR standartą 4K formatu. rezoliucija, kurią turėjo Maxwellas. Be to, „Pascal“ palaiko HEVC formato dekodavimą 4K raiška 60 Hz ir 10 arba 12 bitų spalvomis, kuris naudojamas HDR vaizdo įrašams, taip pat koduojant tą patį formatą tais pačiais parametrais, bet tik 10 bitų HDR vaizdo įrašymui ar transliacijai. Be to, naujovė yra parengta standartizuoti „DisplayPort 1.4“, kad HDR duomenys būtų perduodami per šią jungtį.

Beje, ateityje gali prireikti HDR vaizdo kodavimo, norint tokius duomenis iš namų kompiuterio perkelti į „SHIELD“ žaidimų konsolę, galinčią atkurti 10 bitų HEVC. Tai yra, vartotojas galės perduoti žaidimą iš kompiuterio HDR formatu. Stop, kur galėčiau gauti žaidimų su tokiu palaikymu? „Nvidia“ nuolat bendradarbiauja su žaidimų kūrėjais, kad įgyvendintų šią paramą, suteikdama jiems viską, ko reikia (tvarkyklių palaikymas, kodo pavyzdžiai ir kt.), Kad HDR vaizdai būtų teisingi, suderinami su esamais ekranais.

Išleidus vaizdo plokštę, „HDF“ išvestį palaiko „GeForce GTX 1080“, tokie žaidimai kaip „Obduction“, „The Witness“, „Lawbreakers“, „Rise of the Tomb Raider“, „Paragon“, „The Talos Principle“ ir „Shadow Warrior 2“. Tačiau tikimasi, kad šis sąrašas bus įtrauktas artimiausiu metu. ...

SLI kelių lustų atvaizdavimo pakeitimai

Taip pat buvo keletas pakeitimų, susijusių su patentuota SLI kelių GPU atvaizdavimo technologija, nors to niekas nesitikėjo. SLI naudoja kompiuterinių žaidimų entuziastai, norėdami padidinti našumą iki kraštutinių verčių įdiegdami galingiausias vienos mikroschemos vaizdo plokštes kartu arba norėdami gauti labai didelius kadrų dažnius, apsiribodami keletu vidutinio lygio sprendimų, kurie kartais kainuoja mažiau nei vieną aukščiausios klasės ( sprendimas yra prieštaringas, tačiau jie tai daro). Turėdami 4K monitorius, grotuvai neturi nieko kito, kaip įdiegti porą vaizdo plokščių, nes tokiomis sąlygomis net aukščiausio lygio modeliai negali užtikrinti patogaus žaidimo maksimaliais nustatymais.

Vienas iš svarbių „Nvidia SLI“ komponentų yra tiltai, jungiantys vaizdo plokštes į bendrą vaizdo posistemį ir organizuojantys skaitmeninį kanalą duomenims perduoti tarp jų. „GeForce“ vaizdo plokštėse tradiciškai buvo sumontuotos dvigubos SLI jungtys, kurios buvo naudojamos jungiant dvi ar keturias vaizdo plokštes 3 ir 4 krypčių SLI konfigūracijose. Kiekviena vaizdo plokštė turėjo būti prijungta prie kiekvienos, nes visi GPU siuntė savo pateiktus rėmus į pagrindinį GPU, todėl kiekvienoje kortelėje reikėjo dviejų sąsajų.

Pradedant nuo „GeForce GTX 1080“, visoms „Nvidia Pascal“ pagrįstoms vaizdo plokštėms abi SLI yra susietos, kad padidėtų duomenų perdavimo grafikos plokštėse našumas, o šis naujas dviejų kanalų SLI režimas pagerina našumą ir patogumą rodant vaizdinę informaciją labai didelės raiškos ekranuose. arba kelių monitorių sistemos.

Šiam režimui taip pat reikėjo naujų tiltų, vadinamų SLI HB. Jie vienu metu sujungia porą „GeForce GTX 1080“ vaizdo plokščių per du SLI kanalus, nors naujosios vaizdo plokštės taip pat suderinamos su senaisiais tiltais. Skiriant 1920 × 1080 ir 2560 × 1440 taškų raišką 60 Hz atnaujinimo dažniu, galima naudoti standartinius tiltus, tačiau reiklesniais režimais (4K, 5K ir kelių monitorių sistemos) tik nauji tiltai suteiks geresnių rezultatų kadrų keitimo sklandumo požiūriu, nors senieji veiks. bet šiek tiek blogiau.

Be to, naudojant SLI HB tiltus, „GeForce GTX 1080“ duomenų sąsaja veikia 650 MHz dažniu, palyginti su 400 MHz įprastais SLI tiltais senesniuose GPU. Be to, kai kuriems seniems sunkiems tiltams taip pat yra didesnis duomenų perdavimo dažnis su „Pascal“ architektūros vaizdo mikroschemomis. Padidėjus duomenų perdavimo greičiui tarp GPU per dvigubą SLI sąsają su padidintu veikimo dažniu, lygesnis su ankstesniais sprendimais taip pat pateikiamas sklandesnis rėmelių ekranas:

Taip pat reikėtų pažymėti, kad „DirectX 12“ kelių GPU pateikimo palaikymas šiek tiek skiriasi nuo to, kas buvo įprasta anksčiau. IN naujausia versija grafikos API, „Microsoft“ padarė daug pakeitimų, susijusių su tokių vaizdo sistemų veikimu. Programinės įrangos kūrėjams „DX12“ turi dvi kelių GPU naudojimo galimybes: „Multi Display Adapter“ (MDA) ir „Linked Display Adapter“ (LDA) režimus.

Be to, LDA režimas turi dvi formas: „implicit LDA“ (kurią „Nvidia“ naudoja SLI) ir „Explicit LDA“ (kai žaidimų kūrėjas perima kelių lustų atvaizdavimo valdymo užduotis. MDA ir „Explicit LDA“ režimai buvo ką tik įdiegti sistemoje „DirectX 12“, siekiant pateikti žaidimų kūrėjai turi daugiau laisvės ir lankstumo naudodami kelių lustų vaizdo sistemas. Skirtumas tarp režimų aiškiai matomas šioje lentelėje:

LDA režimu kiekvieno GPU atmintis gali būti susieta su kito atmintimi ir rodoma kaip didelis bendras tūris, žinoma, su visais našumo apribojimais, kai duomenys gaunami iš „svetimosios“ atminties. MDA režimu kiekvieno GPU atmintis veikia atskirai, o skirtingi GPU negali tiesiogiai pasiekti duomenų iš kito GPU atminties. LDA režimas yra sukurtas panašaus našumo kelių lustų sistemoms, tuo tarpu MDA režimas turi mažiau apribojimų, o diskretiški ir integruoti GPU arba diskretiški sprendimai su skirtingų gamintojų lustais gali veikti kartu. Tačiau šis režimas taip pat reikalauja daugiau kūrėjų dėmesio ir darbo programuojant bendradarbiavimą, kad GPU galėtų bendrauti vieni su kitais.

Pagal numatytuosius nustatymus SLI sistema, pagrįsta „GeForce GTX 1080“ kortelėmis, palaiko tik du GPU, o trijų ir keturių mikroschemų konfigūracijos oficialiai nerekomenduojamos naudoti, nes pridėjus trečią ir ketvirtą GPU tampa sunkiau užtikrinti šiuolaikinių žaidimų našumą. Pavyzdžiui, daugelis žaidimų naudojasi galimybėmis centrinis apdorojimo blokas sistemose valdant kelių lustų vaizdo sistemas, taip pat naujuose žaidimuose, vis dažniau naudojamos laikinos (laikinos) technikos, naudojant ankstesnių kadrų duomenis, kuriuose efektyvus kelių GPU veikimas yra tiesiog neįmanomas.

Tačiau išlieka įmanoma operuoti sistemas kitose (ne SLI) kelių lustų sistemose, tokiose kaip „DirectX 12“ MDA arba „LDA Explicit“ režimai arba dviejų lustų SLI sistema su specialiu „PhysX“ fizinių efektų GPU. Bet ką daryti su įrašais pagal etalonus, ar „Nvidia“ jų iš viso atsisako? Ne, žinoma, bet kadangi tokios sistemos pasaulyje yra paklausios beveik keleto vartotojų, tokiems itin entuziastams jie sukūrė specialų entuziastų raktą, kurį galima atsisiųsti iš „Nvidia“ svetainės ir atblokuoti šią funkciją. Norėdami tai padaryti, pirmiausia turite gauti unikalų GPU ID paleisdami specialią programą, tada paprašykite Entuziasto rakto svetainėje ir jį atsisiuntę įdiekite raktą į sistemą, taip atrakindami 3 ir 4 krypčių SLI konfigūracijas.

„Fast Sync“ technologija

Kai kurie pakeitimai įvyko sinchronizavimo technologijose rodant informaciją ekrane. Žvelgiant į ateitį, „G-Sync“ nėra nieko naujo, o „Adaptive Sync“ taip pat nepalaikomas. Tačiau „Nvidia“ nusprendė pagerinti išvesties sklandumą ir sinchronizuoti žaidimus, kurie rodo labai aukštą našumą, kai kadrų dažnis yra pastebimai didesnis nei monitoriaus atnaujinimo dažnis. Tai ypač svarbu žaidimams, kuriems reikalingas minimalus delsimas ir reagavimas, taip pat ten, kur vyksta daugelio žaidėjų mūšiai ir varžybos.

„Fast Sync“ yra nauja vertikalaus sinchronizavimo alternatyva, neturinti vaizdo ašarų vaizdinių artefaktų ir nėra susieta su fiksuotu atnaujinimo dažniu, kuris padidina vėlavimą. Kokia yra vertikalaus sinchronizavimo problema tokiuose žaidimuose kaip „Counter-Strike“: Pasaulinis įžeidimas? Šis žaidimas veikia su galingais šiuolaikiniais GPU keliais šimtais kadrų per sekundę greičiu, o žaidėjas gali pasirinkti: įjungti vertikalų sinchronizavimą ar ne.

Daugelio žaidėjų žaidimuose vartotojai dažniausiai siekia minimalaus delsos ir išjungia „VSync“, vaizde susidaro aiškiai matomos ašaros, kurios yra labai nemalonios net esant dideliam kadrų dažniui. Jei įjungsite vertikalų sinchronizavimą, grotuvas žymiai padidins vėlavimą tarp savo veiksmų ir vaizdo ekrane, kai grafikos vamzdynas sulėtės iki monitoriaus atnaujinimo dažnio.

Taip veikia tradicinis konvejeris. Tačiau „Nvidia“ nusprendė atskirti atvaizdavimo ir atvaizdavimo procesą naudodama „Fast Sync“ technologiją. Tai leidžia GPU daliai, teikiančiai kadrus visu greičiu, toliau dirbti kuo efektyviau, saugant šiuos kadrus specialiame laikinajame paskutinio pateikto buferio režime.

Šis metodas leidžia jums pakeisti rodymo metodą ir pasinaudoti geriausiais „VSync On“ ir „VSync Off“ režimais su mažu delsos laiku, bet be vaizdo artefaktų. Naudojant „Fast Sync“, kadrų srauto valdymas nėra atliekamas, žaidimo variklis veikia ne sinchronizavimo režimu ir nėra liepta laukti, kol bus ištrauktas kitas, todėl vėlavimai yra beveik tokie patys, kaip „VSync Off“ režimu. Bet kadangi „Fast Sync“ savarankiškai pasirenka buferį rodymui ir rodo visą kadrą, taip pat nėra nuotraukų pertraukų.

„Fast Sync“ naudoja tris skirtingus buferius, iš kurių pirmieji du veikia panašiai kaip dvigubas buferis klasikiniame vamzdyne. Pagrindinis buferis (priekinis buferis - FB) yra buferis, iš kurio informacija rodoma ekrane, visiškai perteiktas rėmelis. Atgalinis buferis (BB) yra buferis, į kurį gaunama informacija perteikiant.

Naudojant vertikalų sinchronizavimą didelės kadrų dažnio aplinkoje, žaidimas laukia, kol bus pasiektas atnaujinimo intervalas, kad sukeistų pagrindinį buferį su antriniu buferiu, kad ekrane būtų rodomas visas kadras. Tai sulėtina procesą, o pridėjus papildomų buferių, pvz., Tradicinį trigubą buferį, tik vėluojama.

„Fast Sync“ prideda trečią paskutinį atvaizduotą buferį (LRB), kuris naudojamas visiems ką tik perteiktiems kadrams laikyti galiniame buferyje. Buferio pavadinimas kalba pats už save; jame yra paskutinio visiškai pateikto kadro kopija. Kai ateis momentas atnaujinti pagrindinį buferį, šis LRB buferis nukopijuojamas į pagrindinį kaip visumą, o ne dalimis, kaip iš antrinio, kai vertikalusis sinchronizavimas yra išjungtas. Kadangi informacijos nukopijavimas iš buferių yra neveiksmingas, jie tiesiog keičiasi vietomis (arba pervadina, kaip bus patogiau suprasti), o GP104 pasirodžiusi nauja buferių keitimo logika kontroliuoja šį procesą.

Praktiškai įgalinus naująjį „Fast Sync“ sinchronizavimo metodą, vis tiek gaunamas šiek tiek didesnis vėlavimas, palyginti su visiškai išjungtu vertikaliu sinchronizavimu - vidutiniškai 8 ms daugiau, tačiau ekrane rodomi kadrai visiškai, be nemalonių artefaktų ekrane, plyšant vaizdas. Naujasis metodas gali būti įjungtas iš „Nvidia“ valdymo skydo grafinių nustatymų vertikalaus sinchronizavimo valdymo skyriuje. Tačiau numatytoji reikšmė yra programos valdymas ir jums tiesiog nereikia įgalinti greito sinchronizavimo visose 3D programose; geriau pasirinkti šį metodą specialiai žaidimams su dideliu FPS.

Virtualios realybės technologijos „Nvidia VRWorks“

Šiame straipsnyje mes ne kartą palietėme karštą virtualios realybės temą, tačiau daugiausia tai buvo susiję su kadrų dažnio padidinimu ir mažo vėlavimo užtikrinimu, kurie yra labai svarbūs VR. Visa tai yra labai svarbu ir tikrai yra pažangos, tačiau kol kas VR žaidimai atrodo toli gražu ne tokie įspūdingi, kaip geriausi iš „įprastų“ šiuolaikinių 3D žaidimų. Tai atsitinka ne tik todėl, kad pirmaujantys žaidimų kūrėjai dar nėra ypač įsitraukę į VR programas, bet ir dėl didesnių VR reikalavimų kadrų dažniui, kuris dėl aukštų reikalavimų neleidžia naudoti daugelio įprastų tokių žaidimų būdų.

Siekdama sumažinti VR žaidimų ir įprastų žaidimų kokybės skirtumą, „Nvidia“ nusprendė išleisti visą su „VRWorks“ susijusių technologijų paketą, kuris apėmė daugybę API, bibliotekų, variklių ir technologijų, kurios gali žymiai pagerinti VR kokybę ir našumą. programos. Kaip tai susiję su pirmojo žaidimo sprendimo paskelbimu Pascale? Tai labai paprasta - į jį buvo įtrauktos kai kurios technologijos, kurios padeda padidinti produktyvumą ir pagerinti kokybę, ir mes jau apie jas rašėme.

Ir nors klausimas susijęs ne tik su grafika, pirmiausia mes apie tai šiek tiek pasakosime. Į „VRWorks Graphics“ technologijų rinkinį įeina anksčiau paminėtos technologijos, tokios kaip „Lens Matched Shading“, kuriose naudojama daugelio projekcijų funkcija, pasirodžiusi „GeForce GTX 1080“. Naujas produktas leidžia pasiekti 1,5–2 karto didesnį našumą, palyginti su sprendimais, kurie neturi tokio palaikymo. Mes taip pat paminėjome kitas technologijas, tokias kaip „MultiRes Shading“, skirtos vaizduoti skirtingomis raiškomis rėmo centre ir jo periferijoje.

Tačiau daug netikėtesnis buvo pranešimas apie „VRWorks Audio“ technologiją, skirtą aukštos kokybės garso duomenims apdoroti 3D scenose, o tai ypač svarbu virtualios realybės sistemose. Įprastuose varikliuose garso šaltinių padėtis virtualioje aplinkoje apskaičiuojama gana teisingai, jei priešas šaudo iš dešinės, tada garsas girdimas garsiau iš šios garso sistemos pusės, ir šis skaičiavimas nėra per daug reikalingas skaičiavimo galiai.

Tačiau iš tikrųjų garsai eina ne tik į grotuvą, bet ir į visas puses ir yra atspindimi iš įvairių medžiagų, panašiai kaip ir šviesos spinduliai. Ir iš tikrųjų mes girdime šiuos atspindžius, nors ir ne taip aiškiai, kaip tiesioginės garso bangos. Šie netiesioginiai garso atspindžiai paprastai imituojami specialiais reverb efektais, tačiau tai yra labai primityvus požiūris į užduotį.

„VRWorks Audio“ pakete garso bangos perteikiamos panašiai kaip spindulių atsekimas perteikimo metu, kai šviesos spindulių kelias yra atsekamas iš kelių virtualios scenos objektų atspindžių. „VRWorks Audio“ taip pat imituoja garso bangų sklidimą aplinkoje, kur stebimos tiesioginės ir atspindėtos bangos, atsižvelgiant į kritimo kampą ir atspindinčių medžiagų savybes. Savo darbe „VRWorks Audio“ naudoja didelio našumo spindulių sekimo variklį „Nvidia OptiX“, žinomą dėl grafikos užduočių. „OptiX“ gali būti naudojama atliekant įvairias užduotis, pavyzdžiui, apskaičiuojant netiesioginį apšvietimą ir paruošiant šviesos žemėlapius, o dabar garso bangoms atsekti „VRWorks Audio“.

„Nvidia“ į savo „VR Funhouse“ demonstracinę versiją įtraukė tikslius garso bangų skaičiavimus, kurie naudoja tūkstančius spindulių ir apskaičiuoja iki 12 objektų atspindžių. Norėdami sužinoti technologijos pranašumus naudodami aiškų pavyzdį, siūlome žiūrėti vaizdo įrašą apie technologiją rusų kalba:

Svarbu, kad „Nvidia“ požiūris skiriasi nuo tradicinių garso variklių, įskaitant aparatinės įrangos pagreitintą metodą, naudojant specialų GPU bloką nuo pagrindinio konkurento. Visi šie metodai suteikia tik tikslų garso šaltinių padėties nustatymą, tačiau neapskaičiuoja garso bangų atspindžių iš objektų 3D scenoje, nors jie gali tai imituoti naudodami reverb efektą. Vis dėlto, naudojant spindulių sekimo technologiją, gali būti daug realiau, nes tik tokiu būdu bus galima tiksliai imituoti įvairius garsus, atsižvelgiant į scenoje esančių objektų dydį, formą ir medžiagas. Sunku pasakyti, ar tokio skaičiavimų tikslumo reikia tipiškam žaidėjui, tačiau galime tvirtai pasakyti: VR jis gali vartotojams suteikti patį tikroviškumą, kurio vis dar trūksta įprastuose žaidimuose.

Na, mes tiesiog turime jums papasakoti apie „VR SLI“ technologiją, kuri veikia tiek „OpenGL“, tiek „DirectX“. Jos principas yra labai paprastas: dviejų procesorių vaizdo sistema VR programoje veiks taip, kad kiekvienai akiai būtų skiriamas atskiras GPU, priešingai nei AFR atvaizdavimas, kuris yra įprastas SLI konfigūracijoms. Tai labai pagerina bendrą virtualios realybės sistemoms svarbų našumą. Teoriškai galima naudoti daugiau GPU, tačiau jų skaičius turėtų būti lygus.

Šis požiūris buvo reikalingas, nes AFR nėra tinkamas VR, nes jo pagalba pirmasis GPU pateiks tolygų rėmelį abiem akims, o antrasis - nelyginis, kuris jokiu būdu nesumažina latentų, kurios yra kritinės virtualios realybės sistemoms. Nors kadrų dažnis bus gana didelis. Taigi, naudojant VR SLI, darbas prie kiekvieno kadro yra padalintas į du GPU - vienas veikia kairės akies rėmelio dalyje, kitas - dešinėje, o tada šios kadro pusės sujungiamos į visumą.

Šis darbo pasidalijimas tarp poros GPU atneša beveik 2 kartus didesnį našumą, leidžiantį pasiekti didesnį kadrų greitį ir mažesnį vėlavimą nei vieno GPU sistemos. Tačiau norint naudoti VR SLI reikia specialaus programos palaikymo, kad būtų galima naudoti šį mastelio keitimo metodą. Tačiau „VR SLI“ technologija jau įdiegta VR demonstracinėse programose, tokiose kaip „The Lab from Valve“ ir „Trials on Tatooine“ iš ILMxLAB, ir tai tik pradžia - „Nvidia“ žada neišvengiamą kitų programų pasirodymą, taip pat technologijos įvedimą į žaidimų variklius „Unreal Engine 4“, „Unity“ ir „MaxPlay“.

„Ansel“ žaidimo ekrano kopijos platforma

Vienas įdomiausių su programine įranga susijusių pranešimų buvo išleista technologija, skirta fiksuoti aukštos kokybės ekrano kopijas žaidimų programose, pavadinta garsaus fotografo - Anselio - vardu. Žaidimai jau seniai tapo ne tik žaidimais, bet ir vieta, kur neklaidžiomis rankomis naudojasi įvairūs kūrybingi asmenys. Kažkas keičia žaidimų scenarijus, kažkas išleidžia aukštos kokybės žaidimų tekstūrų rinkinius, o kažkas padaro gražių ekrano kopijų.

„Nvidia“ nusprendė padėti pastarajai, pristatydama naują platformą, skirtą kurti (tiksliai kurti, nes tai nėra toks paprastas procesas) aukštos kokybės paveikslėlius iš žaidimų. Jie mano, kad Anselas gali padėti sukurti naują šiuolaikinio meno rūšį. Juk jau yra nemažai menininkų, kurie didžiąją gyvenimo dalį praleidžia kompiuteryje, kurdami gražius ekrano vaizdus iš žaidimų, ir jie vis dar neturėjo tam patogaus įrankio.

Ansel leidžia jums ne tik užfiksuoti vaizdą žaidime, bet ir pakeisti jį taip, kaip to reikia kūrėjui. Naudodamiesi šia technologija, fotoaparatą galite judinti aplink sceną, pasukti ir pakreipti bet kuria kryptimi, kad gautumėte norimą kadro kompoziciją. Pavyzdžiui, tokiuose žaidimuose kaip šaudyklės iš pirmo asmens, galite judinti tik grotuvą, nieko daugiau pakeisti negalima, todėl visos ekrano kopijos yra gana vienodos. Turėdami nemokamą „Ansel“ fotoaparatą, galite peržengti žaidimo kamerą, pasirinkdami kampą, kurio reikia sėkmingam vaizdui, ar netgi užfiksuoti pilną 360 laipsnių stereofoninį vaizdą iš reikiamo taško, tačiau didelės raiškos, kad vėliau galėtumėte peržiūrėti VR ausinėse.

Ansel veikia gana paprastai - naudojant specialią „Nvidia“ biblioteką, ši platforma yra įterpta į žaidimo kodą. Norėdami tai padaryti, jo kūrėjui reikia tik pridėti nedidelį kodo fragmentą prie savo projekto, kad „Nvidia“ vaizdo tvarkyklė galėtų perimti duomenis iš buferių ir šešėlių. Darbo ten yra labai mažai, „Ansel“ įdiegimas į žaidimą trunka mažiau nei vieną dieną. Taigi, įtraukiant šią funkciją į „The Witness“ žaidimą, reikėjo apie 40 kodo eilučių, o „The Witcher 3“ - apie 150 kodo eilučių.

Ansel pasirodys su atviru kūrimo paketu - SDK. Svarbiausia yra tai, kad vartotojas sutinka su juo standartinį nustatymų rinkinį, leidžiantį jam pakeisti fotoaparato padėtį ir kampą, pridėti efektų ir pan. „Ansel“ platforma veikia taip: pristabdo žaidimą, įjungia nemokamą kamerą ir leidžia pakeisti kadrą į norimą vaizdą, įrašant rezultatas bus įprasta ekrano kopija, 360 laipsnių vaizdas, stereofoninė pora arba tiesiog didžiulės raiškos panorama.

Vienintelė pastaba: ne visi žaidimai sulauks visų kūrimo platformos galimybių palaikymo žaidimo ekrano kopijos Ansel. Kai kurie žaidimų kūrėjai dėl vienų ar kitų priežasčių nenori į savo žaidimus įtraukti visiškai nemokamos kameros - pavyzdžiui, dėl galimybės apgavikams naudoti šią funkciją. Arba jie nori apriboti žiūrėjimo kampo pasikeitimą dėl tos pačios priežasties - kad niekas nesinaudotų nesąžiningu pranašumu. Na, arba taip, kad vartotojai fone nematytų varganų spritų. Visa tai yra gana įprasti žaidimų kūrėjų norai.

Viena įdomiausių „Ansel“ savybių yra tik didžiulės raiškos ekrano kopijų kūrimas. Nesvarbu, kad žaidimas palaiko, pavyzdžiui, iki 4K skiriamąją gebą, o vartotojo monitorius yra „Full HD“. Naudodamiesi ekrano kopijų darymo platforma, galite užfiksuoti daug kokybiškesnį vaizdą, kurį riboja disko tūris ir našumas. Platforma lengvai užfiksuoja iki 4,5 gigapikselių ekrano kopijas, sujungtas iš 3600 vienetų!

Akivaizdu, kad tokiose nuotraukose galite pamatyti visas detales, iki tolumoje gulinčių laikraščių teksto, jei toks detalumo lygis iš esmės yra numatytas žaidime - „Ansel“ gali kontroliuoti detalumo lygį, nustatydamas maksimalų lygį, kad gautų geriausią vaizdo kokybę. Bet jūs taip pat galite įgalinti supersample. Visa tai leidžia jums sukurti vaizdus iš žaidimų, kuriuos galite saugiai atsispausdinti ant didelių reklaminių antraščių ir būti ramūs dėl jų kokybės.

Įdomu tai, kad dideliems vaizdams sujungti naudojamas specialus CUDA pagrįstas aparatinės įrangos pagreitintas kodas. Galų gale jokia vaizdo plokštė negali atvaizduoti viso gigapikselio vaizdo, tačiau tai gali padaryti po gabalėlį, kurį jums tereikia vėliau sujungti, atsižvelgiant į galimą apšvietimo, spalvų ir pan. Skirtumą.

Susegus tokias panoramas, visam kadrui naudojamas specialus vėlesnis apdorojimas, taip pat pagreitintas GPU. Norėdami užfiksuoti didelio dinaminio diapazono vaizdus, \u200b\u200bgalite naudoti specialų vaizdo formatą - EXR, atvirą „Industrial Light and Magic“ standartą, kurio spalvų reikšmės kiekviename kanale įrašomos 16 bitų slankiojo kablelio formatu (FP16).

Šis formatas leidžia pakeisti vaizdo ryškumą ir dinaminį diapazoną apdorojant jį vėliau, pridedant prie norimo kiekvieno konkretaus ekrano, taip pat, kaip tai daroma naudojant RAW formatus iš fotoaparatų. Vėliau taikant filtrus po apdorojimo vaizdo apdorojimo programose, šis formatas yra labai naudingas, nes jame yra daug daugiau duomenų nei įprastuose vaizdų formatuose.

Tačiau pačioje „Ansel“ platformoje yra daugybė papildomo apdorojimo filtrų, o tai ypač svarbu, nes ji turi prieigą ne tik prie galutinio vaizdo, bet ir prie visų žaidimo naudojamų buferių perteikimui, kurie gali būti naudojami labai įdomiems efektams, pavyzdžiui, lauko gyliui. Norėdami tai padaryti, „Ansel“ turi specialų API apdorojimui, o bet kurį iš efektų galima įtraukti į žaidimą su šios platformos palaikymu.

„Ansel post“ filtrai apima tokius filtrus kaip: spalvų kreivės, spalvų erdvė, transformacija, desatūracija, ryškumas / kontrastas, plėvelės grūdelis, žydėjimas, objektyvo paaštrėjimas, anamorfinis akinimas, iškraipymai, viržynai, žuvies akys, spalvų aberacija, tonų atvaizdavimas, objektyvo purvas, šviesos ašys , vinjetė, gama korekcija, konvoliucija, galandimas, kraštų aptikimas, neryškumas, sepija, denoise, FXAA ir kt.

Kalbant apie „Ansel“ palaikymo žaidimuose išvaizdą, turėsite šiek tiek palaukti, kol kūrėjai ją įgyvendins ir išbandys. Tačiau „Nvidia“ žada, kad tokia parama netrukus pasirodys tokiuose garsiuose žaidimuose kaip „The Division“, „The Witness“, „Lawbreakers“, „The Witcher 3“, „Paragon“, „Fortnite“, „Obduction“, „No Man's Sky“, „Unreal Tournament“ ir kt.

Naujasis 16 nm „FinFET“ technologinis procesas ir architektūros optimizavimas leido „GeForce GTX 1080“ vaizdo plokštei, pagrįstai GP104 GPU, pasiekti aukštą 1,6–1,7 GHz taktinį greitį net naudojant standartinę formą, o nauja karta garantuoja veikimą kuo aukščiau žaidimų dažnių. „GPU Boost“ technologija. Šie patobulinimai kartu su padidėjusiu vykdymo vienetų skaičiumi padarė naują produktą ne tik visų laikų našiausią vienos lustos vaizdo plokštę, bet ir efektyviausią energiją taupantį sprendimą rinkoje.

„GeForce GTX 1080“ yra pirmoji vaizdo plokštė, turinti naujo tipo „GDDR5X“ grafikos atmintį - naujos kartos greitaeigius lustus, pasiekiančius labai didelę duomenų perdavimo spartą. „GeForce GTX 1080“ modifikacijos atveju šio tipo atmintis veikia efektyviu 10 GHz dažniu. Kartu su patobulintais informacijos glaudinimo kadrų buferyje algoritmais tai padidino efektyvųjį pralaidumas šio GPU atmintis yra 1,7 karto didesnė už tiesioginio pirmtako „GeForce GTX 980“ atmintį.

„Nvidia“ išmintingai nusprendė neišleisti radikaliai naujos architektūros visiškai naujam techniniam procesui sau, kad kūrimo ir gamybos metu nesusidurtų su nereikalingomis problemomis. Vietoj to, jie rimtai patobulino jau gerą ir labai efektyvią „Maxwell“ architektūrą, pridėdami keletą funkcijų. Todėl gaminant naujus GPU viskas yra gerai, o „GeForce GTX 1080“ modelio atveju inžinieriai pasiekė labai aukšto dažnio potencialą - tikėtose partnerių versijose tikimasi, kad GPU dažnis bus iki 2 GHz! Šis įspūdingas dažnis tapo realybe dėka tobulo techninio proceso ir kruopštaus „Nvidia“ inžinierių darbo kuriant „Pascal“ GPU.

Nors „Pascal“ tapo tiesioginiu „Maxwell“ bylos tęsėju ir šios grafikos architektūros iš esmės nedaug skiriasi viena nuo kitos, „Nvidia“ įgyvendino daugybę pakeitimų ir patobulinimų, įskaitant ekrano galimybes, vaizdo įrašų kodavimo ir dekodavimo variklius, patobulintus asinchroninius atlikdamas įvairių tipų skaičiavimus GPU, pakeitė kelių lustų atvaizdavimą ir pristatė naują „Fast Sync“ metodą.

Neįmanoma neišskirti daugiaprojekcijos „Vienalaikio daugiaprojekcijos“ technologijos, kuri padeda padidinti virtualios realybės sistemų našumą, teisingiau parodyti scenas kelių monitorių sistemose ir įdiegti naujas našumo optimizavimo technikas. Tačiau didžiausią greitį padidins VR programos, kai jos palaiko daugiaprojekcinę technologiją, kuri padeda perpus sutaupyti GPU išteklius apdorojant geometrinius duomenis ir pusantro karto atliekant skaičiavimus pikseliais.

Tarp grynai programinės įrangos pakeitimų išsiskiria ekrano kopijų kūrimo platforma žaidimuose, vadinamuose „Ansel“ - bus įdomu tai išbandyti praktiškai ne tik daugeliui žaidėjų, bet ir tiems, kurie tiesiog domisi aukštos kokybės 3D grafika. Naujovė leidžia perkelti ekrano kopijų kūrimo ir retušavimo meną į kitą lygį. Na, „Nvidia“ tiesiog toliau žingsnis po žingsnio tobulina žaidimų kūrėjų, tokių kaip „GameWorks“ ir „VRWorks“, paketus - taigi pastarajame atsirado įdomi galimybė kokybiškai apdoroti garsą, atsižvelgiant į daugybę garso bangų atspindžių naudojant aparatūros spindulių sekimą.

Apskritai, „Nvidia GeForce GTX 1080“ vaizdo plokštės pavidalu į rinką atėjo tikras lyderis, turintis visas tam reikalingas savybes: aukštą našumą ir platų funkcionalumą, taip pat palaikymą naujoms funkcijoms ir algoritmams. Pirmieji šios vaizdo plokštės pirkėjai galės iš karto įvertinti daugelį paminėtų pranašumų, o kitos sprendimo galimybės atsiskleis šiek tiek vėliau, kai bus platus išorės palaikymas. programinė įranga... Svarbiausia, kad „GeForce GTX 1080“ pasirodė esąs labai greitas ir efektyvus, o kai kurias problemines sritis (tuos pačius asinchroninius skaičiavimus), kaip mes labai tikimės, ištaisė „Nvidia“ inžinieriai.

„GeForce GTX 1070“ grafinis greitintuvas

| Parametras | Vertė |

|---|---|

| Lusto kodinis vardas | GP104 |

| Gamybos technologija | 16 nm „FinFET“ |

| Tranzistorių skaičius | 7,2 mlrd |

| Pagrindinė sritis | 314 mm² |

| Architektūra | Vieningas, su daugybe įprastų procesorių, skirtų srautui apdoroti daugybę duomenų tipų: viršūnių, taškų ir kt. |

| „DirectX“ aparatinės įrangos palaikymas | „DirectX 12“ su palaikymu 12_1 funkcijų lygiu |

| Atminties magistralė | 256 bitų: aštuoni nepriklausomi 32 bitų atminties valdikliai, palaikantys GDDR5 ir GDDR5X atmintį |

| GPU dažnis | 1506 (1683) MHz |

| Skaičiavimo vienetai | 15 aktyvių (iš 20 mikroschemoje) srautinių daugiaprocesorių, įskaitant 1920 (iš 2560) skaliarinius ALU plūduriuojančių taškų skaičiavimams pagal IEEE 754-2008 standartą; |

| Tekstūravimo kaladėlės | 120 aktyvių (iš 160 mikroschemoje) tekstūros adresavimo ir filtravimo įrenginių, palaikančių FP16 ir FP32 komponentus tekstūrose, ir palaikantys trimatį ir anizotropinį visų tekstūros formatų filtravimą |

| Rastrinių operacijų blokai (ROP) | 8 platus ROP (64 pikseliai), palaikantys įvairius antialiazinius režimus, įskaitant programuojamus su FP16 arba FP32 kadrų buferio formatu. Blokai susideda iš konfigūruojamų ALU masyvo ir yra atsakingi už gylio generavimą ir palyginimą, daugialypį rinkimą ir maišymą. |

| Stebėkite palaikymą | Integruotas palaikymas iki keturių monitorių, prijungtų per „Dual Link DVI“, „HDMI 2.0b“ ir „DisplayPort 1.2“ (1.3 / 1.4 parengtis) sąsajas. |

| Nuoroda „GeForce GTX 1070“ specifikacijos | |

|---|---|

| Parametras | Vertė |

| Pagrindinis dažnis | 1506 (1683) MHz |

| Universaliųjų procesorių skaičius | 1920 |

| Tekstūros vienetų skaičius | 120 |

| Maišymo blokų skaičius | 64 |

| Efektyvus atminties dažnis | 8000 (4 × 2000) MHz |

| Atminties tipas | GDDR5 |

| Atminties magistralė | 256 bitų |

| Atminties dydis | 8 GB |

| Atminties pralaidumas | 256 GB / s |

| Skaičiavimo našumas (FP32) | apie 6,5 teraflops |

| Teorinis maksimalus užpildymo greitis | 96 gigapikseliai / s |

| Teorinis tekstūros mėginių ėmimo dažnis | 181 gigatexels / s |

| Padanga | „PCI Express 3.0“ |

| Jungtys | Vienas „Dual Link“ DVI, vienas HDMI ir trys „DisplayPort“ |

| Energijos suvartojimas | iki 150 W |

| Papildomas maistas | Viena 8 kontaktų jungtis |

| Užimtų lizdų skaičius sistemos važiuoklėje | 2 |

| Rekomenduojama kaina | 379–449 USD (JAV), 34 990 USD (Rusija) |

Vaizdo plokštė „GeForce GTX 1070“ taip pat gavo logišką pavadinimą, panašų į tą patį sprendimą iš ankstesnės „GeForce“ serijos. Nuo tiesioginio pirmtako „GeForce GTX 970“ jis skiriasi tik pakeistu kartos numeriu. Naujovė dabartinėje bendrovės linijoje tampa vienu laipteliu žemesnė nei dabartinis aukščiausios klasės sprendimas „GeForce GTX 1080“, kuris tapo laikinuoju naujosios serijos pavyzdžiu iki sprendimų išleidimo dar didesnės galios GPU.

Rekomenduojamos naujos „Nvidia“ aukščiausios klasės grafikos plokštės kainos yra atitinkamai 379 USD ir 449 USD už įprastines „Nvidia“ partnerių versijas ir specialųjį leidimą „Founders Edition“. Palyginti su aukščiausio lygio modeliu, tai yra labai gera kaina, turint omenyje, kad „GTX 1070“ blogiausiu atveju atsilieka apie 25%. Paskelbimo ir išleidimo metu „GTX 1070“ tampa geriausiu savo klasės efektyvumo sprendimu. Kaip ir „GeForce GTX 1080“, taip ir „GTX 1070“ neturi tiesioginių konkurentų iš AMD, jį galima palyginti tik su „Radeon R9 390X“ ir „Fury“.

„GeForce GTX 1070“ modifikacijoje buvo nuspręsta palikti visą 256 bitų atminties magistralę GP104 grafikos procesoriui, nors jie naudojo ne naujo tipo GDDR5X atmintį, o labai greitą GDDR5, veikiantį dideliu efektyviu 8 GHz dažniu. Vaizdo plokštėje, turinčioje tokią magistralę, įdiegtos atminties kiekis gali būti lygus 4 arba 8 GB, o norint užtikrinti maksimalų naujojo sprendimo veikimą esant aukštoms nuostatoms ir pateikimo skiriamosioms geboms, „GeForce GTX 1070“ modelyje taip pat buvo įrengta 8 GB vaizdo atmintis, kaip ir jo vyresniajai seseriai. Šio tūrio pakanka keleriems metams paleisti bet kokias 3D programas su maksimaliomis kokybės nuostatomis.

Specialus „GeForce GTX 1070 Founders Edition“

Gegužės pradžioje paskelbus „GeForce GTX 1080“, buvo paskelbtas specialus grafikos plokštės leidimas „Founders Edition“, kurio kaina yra didesnė nei įprastų kompanijos partnerių vaizdo plokščių. Tas pats pasakytina ir apie naująjį produktą. Šiame straipsnyje vėl pakalbėsime apie specialų „GeForce GTX 1070“ vaizdo plokštės leidimą pavadinimu „Founders Edition“. Kaip ir senesnio modelio atveju, „Nvidia“ nusprendė išleisti šią gamintojo standartinės vaizdo plokštės versiją brangiau. Jie teigia, kad daugelis žaidėjų ir entuziastų, perkančių aukščiausios klasės vaizdo plokštes, nori aukščiausios kokybės išvaizdos ir pojūčio.